Трансформеры — это архитектура, которая изменила подход к обработке естественного языка. Они стали основой для таких моделей, как ChatGPT, и продолжают развиваться, открывая новые горизонты в области искусственного интеллекта.

Содержание

- Революция в обработке естественного языка: от RNN к трансформерам

- Анатомия трансформера: как устроена революционная архитектура

- Механизм внимания: сердце трансформерной архитектуры

- От теории к практике: эволюция масштаба моделей

- Трансформеры в действии: ключевые приложения и достижения

- ChatGPT и другие языковые модели на базе трансформеров

- Преимущества и ограничения трансформерной архитектуры

- Будущее трансформеров: новые горизонты и перспективы

Революция в обработке естественного языка: от RNN к трансформерам

До появления трансформеров доминирующими архитектурами в NLP были рекуррентные нейронные сети (RNN) и их более продвинутые версии, такие как LSTM и GRU. Эти модели казались идеальными для работы с последовательностями текста, поскольку они обрабатывали данные по одному элементу за раз, сохраняя при этом "память" о предыдущих шагах. Однако у RNN было несколько серьезных недостатков. Во-первых, они страдали от проблемы "затухающего градиента". Во-вторых, последовательная природа обработки данных делала их крайне неэффективными для параллельных вычислений. В-третьих, RNN плохо справлялись с зависимостями между словами, расположенными далеко друг от друга в тексте.

В 2017 году исследователи из Google представили статью "Attention is All You Need", которая перевернула мир NLP. В ней была описана новая архитектура — трансформеры, которые полностью отказались от рекуррентных связей. Вместо этого они использовали механизм внимания (attention mechanism), позволяющий модели одновременно анализировать все слова в предложении, устанавливая связи между ними независимо от их положения. Это был прорыв, который позволил решить многие проблемы RNN.

Анатомия трансформера: как устроена революционная архитектура

Трансформеры — это сложные многослойные нейронные сети, каждая часть которых играет важную роль в обработке данных. Архитектура трансформера состоит из двух основных компонентов: кодировщика (encoder) и декодера (decoder). Кодировщик преобразует входной текст в последовательность векторов, содержащих информацию о контексте, а декодер использует эти векторы для генерации выходного текста.

Основные компоненты трансформера включают слой позиционного кодирования, многоголовый механизм внимания, полносвязные слои, нормализацию и остаточные связи. Позиционное кодирование добавляет информацию о порядке слов, а механизм внимания позволяет модели сосредоточиться на наиболее релевантных частях текста.

Механизм внимания: сердце трансформерной архитектуры

Если бы трансформеры можно было сравнить с живым организмом, то механизм внимания был бы их сердцем. Именно он обеспечивает уникальную способность модели фокусироваться на наиболее важных частях текста и устанавливать сложные зависимости между словами.

Механизм внимания принимает три входных вектора: запрос (query), ключ (key) и значение (value). Запрос представляет текущее слово, для которого модель пытается найти релевантный контекст. Ключи и значения — это векторы, представляющие другие слова в тексте. Модель вычисляет "внимание" между запросом и каждым ключом, а затем использует эти веса для взвешенного суммирования значений.

От теории к практике: эволюция масштаба моделей

Первая версия трансформеров, представленная в 2017 году, уже показала впечатляющие результаты. Однако истинный потенциал этой архитектуры стал очевиден только с появлением моделей огромного масштаба, таких как GPT-3, BERT и T5. Эти модели содержат миллиарды параметров и обучены на огромных корпусах текста, что позволяет им демонстрировать почти человеческий уровень понимания языка.

Трансформеры в действии: ключевые приложения и достижения

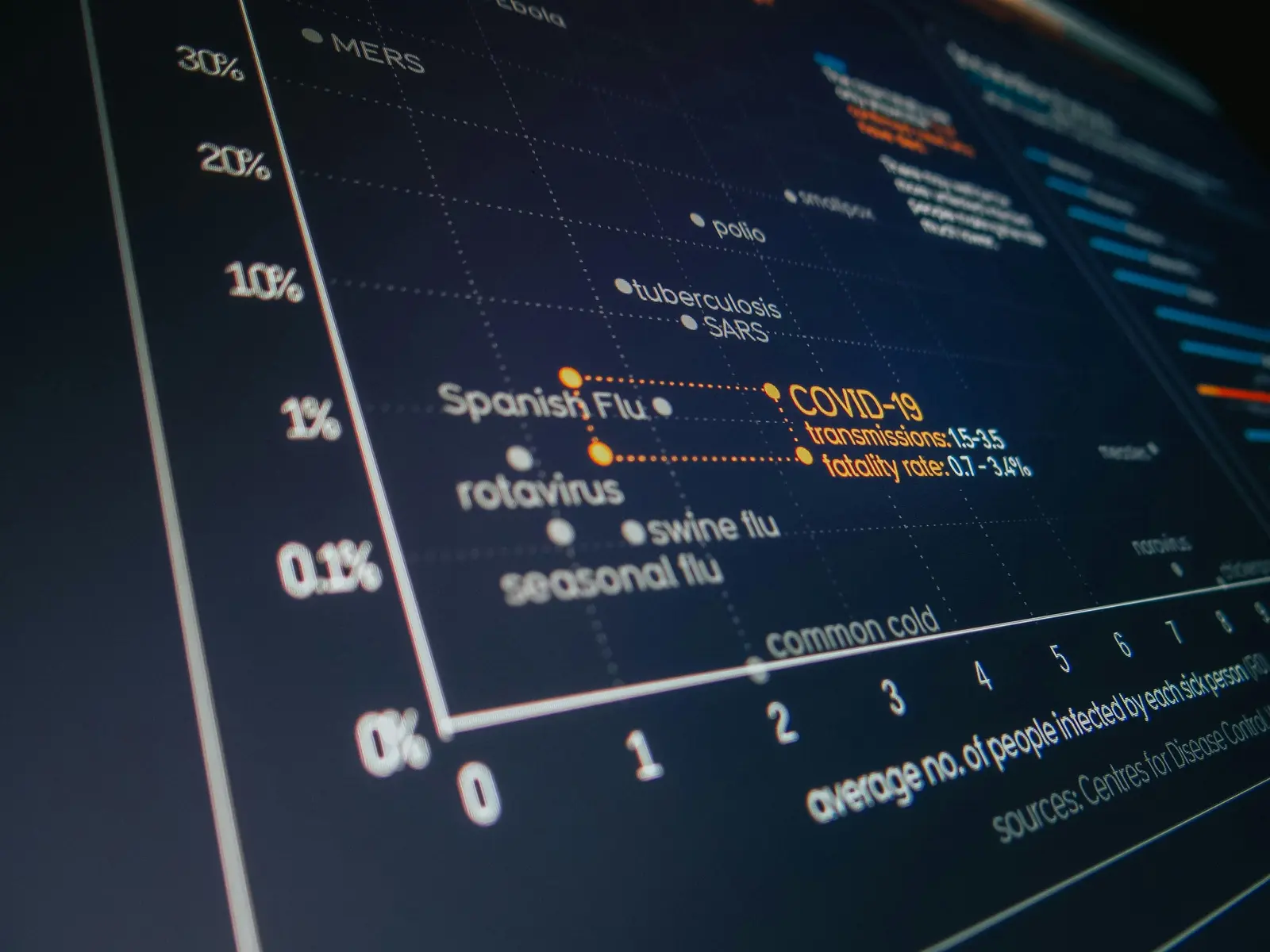

Трансформеры нашли применение практически во всех областях NLP. Они используются для машинного перевода, генерации текста, анализа тональности, классификации документов и многих других задач. Особенно впечатляющими являются их успехи в генерации естественного текста, который практически невозможно отличить от текста, написанного человеком.

ChatGPT и другие языковые модели на базе трансформеров

ChatGPT — это яркий пример того, как трансформеры могут быть использованы для создания интеллектуальных систем, способных поддерживать сложные диалоги. Она основана на архитектуре GPT-3 и обучена на огромном корпусе текста, что позволяет ей понимать контекст и генерировать релевантные ответы.

Преимущества и ограничения трансформерной архитектуры

Несмотря на свои успехи, трансформеры имеют и свои ограничения. Одним из главных недостатков является их высокая вычислительная сложность, особенно при работе с длинными последовательностями. Кроме того, они требуют огромных объемов данных для обучения, что делает их менее доступными для небольших проектов.

Будущее трансформеров: новые горизонты и перспективы

Трансформеры продолжают развиваться. Исследователи экспериментируют с новыми архитектурами, такими как Vision Transformers (ViT) для обработки изображений, и пытаются адаптировать их для решения задач в других областях, таких как биоинформатика и физика. Впереди нас ждут еще более впечатляющие достижения, которые изменят нашу жизнь.

Трансформеры остаются одной из самых перспективных архитектур в области искусственного интеллекта. Их развитие продолжает удивлять и вдохновлять, открывая новые возможности для взаимодействия человека и машин.